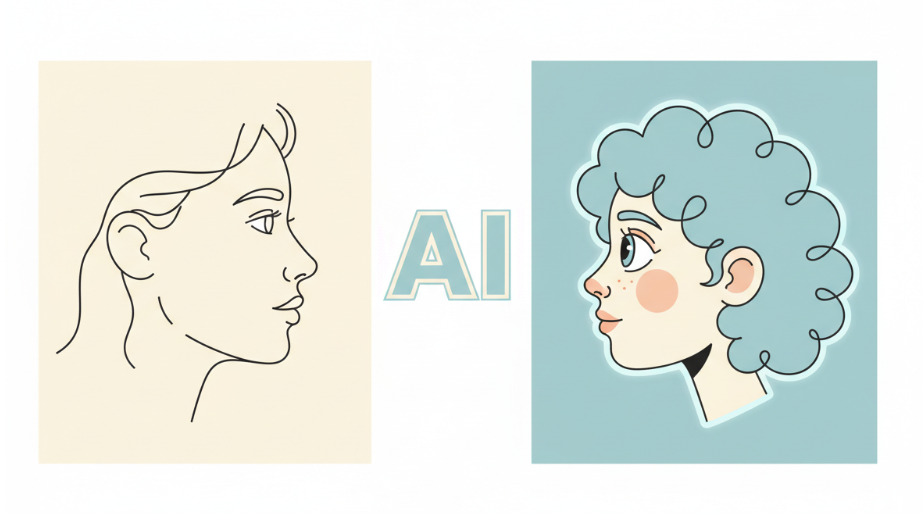

最近总有人问我,网上那些超火的AI漫画脸、卡通头像到底是怎么做的。是不是得懂什么复杂的技术?其实完全不用,现在把一张普通照片变成AI图,比点外卖还简单。你只需要一部手机或一台电脑,几分钟就能搞定。

这事儿听起来好像很神奇,背后的原理其实就是AI模型在“看”了无数张图片之后,学会了不同风格的画法。你给它一张照片,它就能把照片里的人或物,用它学到的漫画、油画或者其他什么风格重新“画”一遍。整个过程,我们普通用户要做的,就是上传照片,然后选个自己喜欢的风格,AI就会自动处理。

市面上的工具五花八门,有手机App,有网站,还有一些更专业的软件。它们操作难度不一样,生成的效果也各有千秋。下面我就把我知道的方法都掰开揉碎了讲给你听,保准你能找到适合自己的那一款。

最简单的方法:手机App一键生成

如果你就是想尝个鲜,给自己的社交媒体换个有趣的头像,那手机App绝对是最方便的选择。这类App的特点就是操作无脑,点几下就出图。

最常见的这类应用叫”AI Art Generator”或者“AI Cartoon Maker”。你在应用商店里搜一下,会出来一大堆。比较有名的像是Lensa AI、Meitu、Remini等等。 它们大都内置了很多现成的艺术风格,比如日式漫画、迪士尼公主风、皮克斯动画风、素描风等等。

具体怎么用呢?我拿一个我之前用过的App来举例,操作流程基本都一样:

- 下载和安装:先去你的手机应用商店(App Store或Google Play)下载一个评价还不错的App。

- 上传照片:打开App,它通常会让你从相册里选一张照片。这里有个小技巧,最好选一张五官清晰、光线好的正面照,这样AI识别起来更准确,效果也更好。背景杂乱或者脸部有遮挡的照片,生成出来的图可能会有点奇怪。

- 选择风格:上传之后,App会展示出各种各样的风格让你选。你喜欢漫画风,就点“Cartoon”;喜欢油画,就选“Oil Painting”。每个风格点一下,它就会开始处理。

- 等待和保存:处理过程通常需要十几秒到一分钟,具体看你的网络情况和服务器忙不忙。生成之后,App会给你看效果图。一般还会提供微调的选项,比如调整一下相似度,或者换个背景。你满意了,直接保存到手机相册就行。

这种方法的优点是快,而且特别容易上手,完全不需要任何学习成本。缺点也很明显,就是自由度低。你只能在App提供的有限风格里选,没法自己创造新的风格。而且,很多App是免费下载,但里面的好看风格或者高清图片下载功能是需要付费订阅的。它们通常会提供几次免费试用机会,你可以先试试看效果再决定要不要花钱。

更自由的选择:在线AI绘画网站

如果你觉得手机App的风格太少了,想玩点更个性化的,那可以试试在线的AI绘画网站。这类网站的功能比App强大一些,自由度也更高。比较知名的有Midjourney、Stable Diffusion Online、Canva的Magic Media等等。

这些网站的核心功能通常是“文生图”(Text-to-Image),就是你输入文字描述,AI给你生成图片。但它们大都也支持“图生图”(Image-to-Image)功能,这正是我们把照片变成AI图所需要的。

用网站来生成AI图,步骤会比手机App稍微多一点,但也不复杂:

- 注册和登录:大部分网站都需要你用邮箱或者Google账号注册一个账户才能使用。

- 找到“图生图”功能:登录进去之后,你要在网站的操作界面里找到类似“Image to Image”、“Img2Img”或者“AI-ify”这样的选项。

- 上传你的照片:和手机App一样,把你想转换的照片传上去。

- 输入“提示词”(Prompt):这是和手机App最大的不同之处。你需要用文字告诉AI你想要什么样的风格。比如说,你想把一张自拍变成《海贼王》的风格,你就可以在提示词框里输入“a man in the style of One Piece anime, vibrant colors, dynamic lines”。提示词写得越具体,AI就越能理解你的想法,生成出来的图也就越接近你想要的。你可以描述风格、画师、颜色、光线等等。如果你不知道怎么写,很多网站会提供一些风格预设或者提示词示例供你参考。

- 调整参数:很多网站还提供一些高级参数给你调整,比如“相似度”(Denoising Strength或Image Weight)。这个参数决定了生成图和原图的相似程度。数值越高,AI发挥的空间就越大,画面风格会很突出,但可能就不太像原来的人了;数值越低,AI就越忠于原图,细节保留得更多,但风格感就没那么强。你可以多试几次,找到一个自己喜欢的平衡点。

- 生成和下载:设置好之后,点击“生成”(Generate)按钮。网站处理图片也需要一点时间。生成结果出来后,不满意可以重新生成或者修改提示词再试,满意了就可以下载保存了。

在线网站的优点是自由度高,你可以通过调整提示词和参数,创造出几乎任何你想象得到的风格。而且很多网站提供免费的生成次数。缺点是需要一点点学习成本,主要是学习怎么写好提示词。有时候为了得到一张满意的图,可能需要反复尝试和修改。

专业玩家的选择:本地部署Stable Diffusion

如果你对AI绘画产生了浓厚的兴趣,不满足于现有的工具,想完全掌控整个过程,甚至训练自己的专属风格,那么你可以在自己的电脑上部署Stable Diffusion。

Stable Diffusion是一个开源的AI绘画模型,这意味着任何人都可以免费下载和使用它。 你可以把它理解成一个AI绘画的引擎。要在你自己的电脑上运行它,你需要一个不错的显卡,通常建议是NVIDIA的显卡,显存至少在6GB以上,当然越高越好。

本地部署的玩法就非常深入了:

- 安装和配置:你需要先安装一些必要的软件,比如Python、Git,然后下载Stable Diffusion WebUI(一个方便操作的用户界面)。整个安装过程对于新手来说可能会有点挑战,需要跟着网上的教程一步步来。

- 下载模型:光有引擎还不行,你还需要下载“模型文件”(Checkpoint/Model)。这些模型决定了AI能画出什么样的基础风格。网上有很多分享模型的网站,比如Civitai,上面有成千上万个不同风格的模型,有专门画二次元的,有专门画写实照片的,也有专门画水墨画的。你可以根据自己的喜好下载。

- 使用图生图功能:在WebUI界面里,同样有“图生图”(img2img)的选项卡。操作和在线网站类似,上传照片,写提示词。

- 高级控制:本地部署的强大之处在于,你可以进行极其精细的控制。除了调整相似度,你还可以使用ControlNet这样的插件来精确控制生成图像的构图、人物姿势、线条等等。 比如说,你可以让AI完全复制原图里人物的动作,只改变画面风格。你还可以加载LoRA(Low-Rank Adaptation)模型,这是一种小型的风格模型,可以让你在不更换主模型的情况下,给画面添加特定的角色特征或者画风。

举个例子,我想把一张朋友在篮球场的照片变成热血的篮球漫画风格。我可以在本地部署的Stable Diffusion里,上传这张照片,然后选择一个专门画日式少年漫画风格的主模型。在提示词里,我写上“a basketball player, dynamic action pose, shonen manga style, screen tones, speed lines”。然后,我再用ControlNet里的OpenPose功能来锁定朋友的投篮姿势,确保AI生成的动作和原图一模一样。最后再加载一个能画出井上雄彦风格的LoRA。这样一番操作下来,生成的图片不仅风格到位,而且还能完美还原照片里的精髓。

本地部署的优点是拥有极致的自由度和控制力,而且完全免费,你想生成多少张就生成多少张。缺点是门槛最高,不仅对电脑硬件有要求,还需要你投入时间去学习和研究各种模型、插件的用法。

总的来说,把照片生成AI图这件事,丰俭由人。只想简单玩玩,手机App最省事;想有点个性化,在线网站能满足大部分需求;如果你是个技术爱好者,喜欢折腾,那本地部署Stable Diffusion会给你打开一个新世界的大门。不管你选择哪种方式,亲手把自己或者朋友的照片变成一张有趣的AI作品,这个过程本身就挺有意思的。

技能提升网

技能提升网